Algorithmen kennen (keine) Vorurteile

Von: Kerstin Prothmann

Es war einmal die Idee der anonymen Bewerbung (Weber, 2014). Personaler und Chefs sollten sich nicht von Alter, Schönheit, Migrationshintergrund oder Geschlecht blenden lassen, sondern objektiv nach Ausbildung und Berufserfahrung entscheiden (Gros, 2012). Wäre es nicht schön, wenn man Mehmet wegen seines Namens nicht gleich mangelnde Ausdrucksfähigkeit oder Hans-Jürgen wegen seines Alters viele Krankheitstage unterstellen würde? Natürlich trauen wir auch Frauen zu, Teams führen zu können, aber bei der zierlichen Silke mit den langen blonden Haaren haben wir Zweifel?

Auch wenn die Idee von anonymen Bewerbungen ohne Altersangabe, Foto, Name überzeugend klingt – durchgesetzt in der Breite hat sie sich nicht. Ganz im Gegenteil – viele Arbeitnehmer teilen bereitwillig nicht nur ihr Privatleben auf Facebook, sondern auch für jeden sichtbar ihre berufliche Entwicklung auf LinkedIn und Xing.

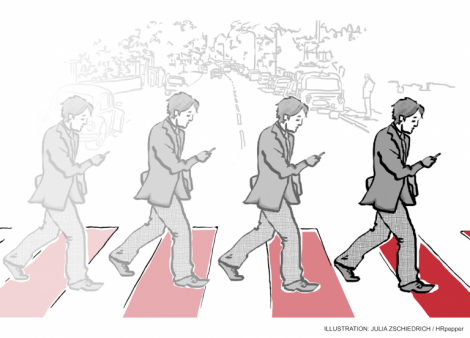

Es scheint also an der Zeit zu sein, die Entscheidung über Einstellung und Beförderung nicht mehr dem vorurteilsbehafteten Menschen allein zu überlassen. Computer-Algorithmen können die Auswahl von Bewerbern unterstützen, auch wenn die letzte Entscheidung beim Menschen liegt. Personalauswahl und –förderung könnten sich stärker an objektiven Tatsachen orientieren, Bewerberinnen mit Migrationshintergrund würden nicht schon beim ersten Blick aufs Foto aussortiert.

Wie funktionieren diese Algorithmen, auch Künstliche Intelligenz genannt? Die in unserem Zusammenhang zur Anwendung kommende Methode ist die Mustererkennung. Computerprogramme analysieren große Datenmengen, z.B. mit Lebensläufen, Qualifikationen und Beurteilungen und erkennen Muster: es könnte beispielsweise sein, dass Mitarbeiterinnen und Mitarbeiter der internen Revision dann erfolgreicher sind, wenn sie zuvor in einer Fachabteilung des Unternehmens gearbeitet haben und nicht direkt von einer Wirtschaftsprüfungsgesellschaft kommen. Es könnte auch sein, dass Controller besonders dann erfolgreich sind, wenn Sie Marketing oder Personalwesen als Nebenfach studiert haben. Es könnte sich herausstellen, dass der Karriereerfolg im Marketing unabhängig vom Studienfach ist. Diese Muster können dann verwendet werden, um die Eignung von Personen für bestimmte Stellen vorherzusagen oder um im Talentpool des Unternehmens geeignete Mitarbeiterinnen oder Mitarbeiter für freiwerdende Positionen zu finden. Durch diese objektive Herangehensweise könnte Diskriminierung auf Grund von Homophilie oder Vorurteilen reduziert werden. Es gibt schon eine Reihe von Softwareanbietern, die solche Ansätze integrieren (SAP Successfactors, Saba), die Funktionen werden häufig zusammengefasst unter dem Oberbegriff „Talent Analytics“.

Wird also der vorurteilsbehaftete Mensch abgelöst durch meritokratische Talent Analytics Systeme? Leider zeigen empirische Studien, dass darauf kein Verlass ist. Eine Studie der US-amerikanischen Carnegie Mellon University zeigte beispielsweise, dass weiblichen Personen von Google deutlich weniger Anzeigen für hochbezahlte Stellen angezeigt werden als männlichen Personen (Amit Datta, 2015). Wenn Frauen aber die gutbezahlten Stellen nicht einmal mehr zu sehen bekommen, können sie sich auch nicht bewerben. Die Ursache für diese faktische Diskriminierung sehen die Forscher nicht in den Wünschen oder Einstellungen der einstellenden Unternehmen oder in einer entsprechenden Vorkonfiguration durch Google (Spice, 2015). Es ist vielmehr so, dass der Algorithmus, welcher die Anzeigenschaltung entsprechend den (vermeintlichen) Interessen der Internetnutzer optimiert und welcher von den Forschern nur als Black Box betrachtet werden kann, zu dem Ergebnis gekommen ist, dass Frauen eine geringere Klickwahrscheinlichkeit auf solche Anzeigen haben als Männer. Der vermeintlich neutrale Algorithmus reproduziert also nur das bereits vorhandene gesellschaftliche Phänomen – Mustererkennung eben!

Ähnliche Arten der Diskriminierung durch Algorithmen der künstlichen Intelligenz wurden auch in ganz anderen Anwendungsgebieten beobachtet: eine im US Justizsystem weit verbreitete Software bewertet die Gefahr von Kriminellen rückfällig zu werden, u.a. an Hand von einem Fragebogen. Eine Studie der Journalistenorganisation ProPublica zeigte, dass der Risiko-Score, die Wahrscheinlichkeit Bürgerinnen und Bürger mit schwarzer Hautfarbe erneut straffällig zu werden, deutlich überschätzt (Julia Angwin, 2016).

Die zunehmende Verbreitung von vermeintlich intelligenten Algorithmen, auch im Personalbereich, ist also mit einer Reihe von Chancen und Risiken verbunden. Intelligente Algorithmen können Personalern helfen, vielversprechende Talent-profile effizient und vorurteilsfrei zu erkennen. Weil aber solche Profile auf Mustern der Vergangenheit basieren, besteht die immanente Gefahr, dass sie dazu beitragen, vorhandene Strukturen zu replizieren, zu erhalten und zu verfestigen: haben sich in der Vergangenheit verheiratete Männer von Elite-Hochschulen als vermeintlich erfolgreich (gemessen an der Beurteilung) erwiesen, so wird der Algorithmus solche Personen wieder vorschlagen. Solche sich selbst reproduzierenden Talentpools sind insbesondere in einem dynamischen Umfeld nicht wünschenswert.

So hilfreich die Methoden der Künstlichen Intelligenz auch sind – sie dürfen nicht als Black Box eingesetzt werden. Ein zumindest grundlegendes Verständnis ihrer Wirkungsweise und ihrer Zwischenergebnisse ist notwendig für die kritische Verwendung ihrer Resultate.

Quellen